ساخت robots.txt و بهینه سازی robots txt در وردپرس

seo سایت اهمیت زیادی برای ارتقاء سایت و بهتر دیده شدن توسط موتورهای جستجو دارد. یکی از فاکتورهای مهم بهینهسازی robots.txt در وردپرس است. فایل robots.txt یک ابزار قدرتمند برای شما به حساب میآید و به عنوان شخصی که به سئوی وبسایتتان اهمیت میدهید، حتما باید آن را در نظر بگیرید.

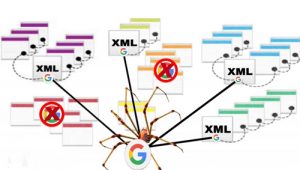

ساخت robots.txt وردپرس و بهینه سازی robots txt می تواند به شما کمک کند تا دسترسی لازم برای موتورهای جستجو را برای دایرکتوری یا همون پوشههای موجود در هاستتون تعیین کنید تا با اینکار به موتورهای جستجو اجازه می دهید که چه آدرسهایی را مورد بررسی قرار بدن و چه آدرسهایی رو نمی توانند بررسی کرده و در خودشون ایندکس کنند را تعیین کنید. مهمترین خاصیتی که با ساخت robots.txt وردپرس می توانید به دست بیاورید این است که در واقع یک حریم خصوصی برای هاست خودتون تعیین میکنید تا به این وسیله موتورهای جستجو نتوانند پوشهای از هاست شما که شامل تصاویر خصوصی و فایلهایی که براتون جنبه خصوصی را دارند بررسی کنند و اما برای ربات های جستجوگر هم این امر باعث می شود تا سایتهایی که دارای فایل robots.txt دارند را بهتر درک کرده و تو جاهایی که بهشون دسترسی داده نشده کمتر سرک بکشند. به همین خاطره که گاهی اوقات می بینیم که وقتی دنبال یک نتیجه از سایتی هستیم با پیغام به علت robots txt این سایت توضیحی برای این نتیجه در دسترس نیست مواجه می شویم. رباتهای جستجوگر به محض ورود به سایتی ابتدا این فایل را بررسی میکنند تا ببینند به چه دایرکتوریهایی دسترسی دارند و بعد از اینکه وظیفه و مسیرشون مشخص شد شروع به بررسی کامل یک سایت میکنند.

ساخت robots.txt وردپرس و بهینه سازی robots.txt

برای ساخت فایل robots.txt وردپرس ابتدا وارد هاست خود بشوید و بعد از ورود روی File Manager کلیک کنید تا به فایل منیجر هاست هدایت شده و بتوانید فایلهای موجود در هاست را کنترل کنید.

بررسی کامل وبسایت توسط گوگل

گوگل تمامی بخشهای یک وبسایت را تحت نظارت و بررسی قرار می دهد. یکی از مواردی که باید در بهینهسازی robots.txt در وردپرس در نظر داشته باشید، این است که هرگز فایلهای CSS و جاوا اسکریپت را مسدود نکنید. بسیاری از بهترین قالبهای وردپرس، درخواستهای ناسازگاری با جاوا اسکریپت ارسال میکنند که به آنها ایجکس گفته میشود و به محتوا یا هر امکان دیگری در صفحات وب اضافه میشوند. خوشبختانه این مشکلات در وردپرس ۴٫۴ برطرف شد و هسته وردپرس نیز بروزرسانی گردید.

robots.txt برخی لینکها را نادیده میگیرد

نکته داشته باشید اگر از robots.txt برای مسدود کردن آدرس یا urlها استفاده میکنید، مانع از بررسی موتورهای جستجو در وبسایتتان خواهید شد. این بدان معناست که مانع از توزیع لینکهای با ارزش در urlها خواهید شد. اگر در بخشی از وبسایت لینکهای زیادی موجود است و نمیخواهید در موتور جستجو نمایش داده شود، آن را توسط robots.txt بلاک نکنید بلکه به جای آن از no-index و nofollow کمک بگیرید. اینگونه به موتورهای جستجو این امکان را میدهید تا به طور مناسب لینکها را در وبسایت توزیع کنند.

نکته بسیار مهمی که باید در نظر داشته باشید این است که اگر از robots.txt برای مسدود کردن آدرس یا urlها استفاده میکنید، مانع از بررسی موتورهای جستجو در وبسایتتان خواهید شد یعنی مانع از توزیع لینکهای با ارزش در urlها خواهید شد. اگر در بخشی از وبسایت لینکهای زیادی موجود است و نمیخواهید در موتور جستجو نمایش داده شود، آن را توسط robots.txt بلاک نکنید بلکه به جای آن از no-index و nofollow کمک بگیرید. اینگونه به موتورهای جستجو این امکان را میدهید تا به طور مناسب لینکها را در وبسایت توزیع کنند.

ساخت robots.txt وردپرس و بهینه سازی robots.txt

برای ساخت فایل robots.txt وردپرس ابتدا وارد هاست خودتون بشید و بعد از ورود روی File Manager کلیک کنید تا به فایل منیجر هاست هدایت شده و بتوانید فایلهای موجود در هاست را کنترل کنید.

بعد از کلیک روی این دکمه به مسیر /public_html/ مراجعه کنید تا به مسیری که وردپرس در اون نصب هست برسید. اگر وردپرس روی دامنه اصلی شما نصب شده کافیه توی همین مسیر باشید اما اگر در پوشه جدایی اونو نصب کردید باید وارد همان پوشه از هاست خودتون بشوید. حالا که به مسیر درست رسیدید با استفاده از برنامه notepad یا هر نرمافزار ویرایشگر متن که دارید یک فایل با نام robots.txt و همین فرمت بسازید و با کلیک روی دکمه آپلود در فایل منیجر هاست اونو به این مسیر اضافه کنید. یا اینکه با کلیک روی دکمه FILE+ کلیک کنید تا پنجرهای مشابه تصویر زیر براتون باز بشود و بعدش نام فایل را در فیلد New File Name با نام robots.txt وارد کنید و در نهایت روی دکمه Create New File کلیک کنید تا فایل شما ساخته شود.

به طور کلی فایل robots.txt از دو دستور و قانون پیروی میکنه که عبارتند از:

User-agent: این دستور نشان می دهد که میتوانید تعیین کنید چه نوع رباتی قادر به دسترسی به دایرکتوریهای تعیین شده در هاست شما خواهد بود. منظور از نوع ربات اینه که ربات کدوم سایت و یا موتور جستجو میتونه تا از این دستورات پیروی کنه

Disallow: این دستور به ربات اجازه ورود به چه مسیرهایی در هاست شما را نخواهد داشت.

بنابراین شما با استفاده از این دو دستور میتونید تا قوانین مختلفی را برای هریک از رباتهای موتورهای جستجو و سایتها تعیین کنید تا عدم دسترسی به دایرکتوریهای گوناگون در هاست خودتون را تعیین کنید. اما برای استفاده از هر ربات ابتدا لازمه تا با لیست رباتهایی که تا به امروز ساخته شدند آشنا شوید. برای این کار میتوانید با کلیک روی دکمه زیر کلیه رباتهای اینترنتی که تا به امروز برای خزش سایتها ساخته شدند دسترسی داشته باشید.

User-agent: با استفاده از این دستور میتونید تا یک قانون را برای همه ربات ها و یا یک ربات خاص تعیین کنید. به عنوان مثال اگر شما داخل هاستتون پوشه ای با نام parsnevis دارید و میخواین که دسترسی به این پوشه برای کلیه رباتها فراهم نباشه کافیه تا در سطر اول User-agent را وارد کرده و مقدار اون را روی کاراکتر * تعیین کنید و بعدش با دستور /disallow: /parsnevis دسترسی به این پوشه را برای کل رباتها غیرفعال کنید. در این صورت هر رباتی که وارد سایت شما بشه از این قانون تبعیت کرده و وارد پوشه parsnevisدر هاست شما نخواهد شد. پس به صورت کلی ساختاری که برای این حالت تعیین میکنید باید دستور زیر را در فایل robots.txt وارد کنید. برای این کار کافی است تا روی فایل robots.txt که در هاست شما قرار داره راست کلیک کرده و گزینه Edit را انتخاب کنید.

تعیین سطح دسترسی به ربات خاص با فایل robots.txt وردپرس همه ما ممکنه تا گاهی به این نیاز پیدا کنیم تا تصویری را در هاست خودمان آپلود کنیم و در اختیار دیگران قرار بدیم که نمی خواهیم این تصویر در دسترس عموم کاربران قرار بگیرد پس برای اینکه این تصویر توسط موتورهای جستجو ایندکس نشویم باید از طریق فایل robots.txt اقدام کنیم.

گوگل دارای رباتهای گوناگونی هست که هر کدوم از این رباتها وظیفه بررسی و خزش محتوای خاصی از سایتها را دارند. به عنوان مثال معروفترین ربات گوگل که با نام Googlebot شناخته شده وظیفه بررسی و ایندکس صفحات را دارد که بعد از ثبت سایت در گوگل کار خودش را برای سایت ما آغاز میکند. یا ربات Googlebot-image وظیفه بررسی و ایندکس تصاویر را داره که در این مثال ما باید از این بات برای غیرفعال کردن دسترسی این بات به تصویر خودمون استفاده کنیم. بنابراین مشابه مثال قبل ابتدا با استفاده از دستور User-agent ربات خودمون را تعیین میکنیم. در اینجا چون شامل یک ربات هست دیگه نباید از ستاره استفاده کرد و باید نام ربات را بنویسیم بعدش در خط بعدی هم با استفاده از دستور Disallow دسترسی به پوشهای که تصویر در اون قرار داره را لغو میکنیم. به صورت کلی دستور ما مشابه زیر خواهد بود.

user-agent: Googlebot-image

disallow: /parsnevis/

در اینجا parsnevisهم همون پوشه ای هست که تصویر در این مسیر از هاست قرار داره. بنابراین بعد از ذخیره کردن فایل دیگه ربات گوگل همچین آدرسی را مورد بررسی قرار نداده و تصویر شما توسط گوگل ایندکس نخواهد شد.

Disallow: /

برای عدم دسترسی به یک پوشه خاص کافیه تا نام اون پوشه و یا زیر پوشههای اونو وارد کنید.

Disallow: /blog/

Disallow: /blog/file/

برای محدود کردن به دسترسی به یک فایل میتوانید تا به شکل زیر عمل کنید.

Disallow: /images/dogs.pdf

Disallow: /files/project.pdf

برای محدود کردن فایلهایی به فرمت خاص در کل سایت میتوانید تا از دستور زیر استفاده کنید.

Disallow: /*.pdf$

Disallow: /*.docs$

لیست کلیه دستورات قابل استفاده در robots.txt

برای تعیین دسترسی برای هر ربات کافیه تا با دستور user-agent اونو تعیین کنید. اگر ربات خاصی مد نظر دارید نام ربات را وارد کنید اما اگر همه رباتها مدنظر شماست کافی است تا مقدار این دستور را روی * قرار بدید. برای هر قانونی که تعیین می کنید باید از user-agent جدا استفاده کنید و سپس مسیری که میخواهید تا دسترسی به اون را لغو کنید را بر اساس زیر وارد کنید. اگر قصد دارید تا دسترسی به کل سایت را غیرفعال کنید میتونید از مشابه دستور زیر برای Disallow استفاده کنید.

با robots.txt چه باید کرد؟

وارد کنسول گوگل شوید و در زیر گزینه Crawl به گزینه Fetch and google میرسید، از گزینه Fetch and render options استفاده کنید.

چنانچه با وارد کردن وبسایتتان در این بخش و کلیک روی گزینه مورد نظر با خطاهایی مواجه شدید و سایت را دقیقا همانند آنچه در مرورگر باز میگردید، مشاهده نکردید باید در صدد رفع آن خطاها باشید و برای بهینهسازی robots.txt در وردپرس، آن خطاها را در این فایل یافته و حذف کنید.

مطالب مرتبط:

ساخت نقشه وردپرس sitemap با google XML sitemap

مشاهده و نمایش سریع محصولات در ووکامرس

مشاهده و نمایش سریع محصولات در ووکامرس

درباره Mostafa Shoa

مدیر تیم پارس نویس، کارشناس مهندسی نرم افزار، مدرس دوره های برنامه نویسی و طراحی سایت در مدارس تیزهوشان، مشاور تبلیغات و بازاریابی استارتاپ ها و کسب و کارهای اینترنتی

نوشته های بیشتر از Mostafa Shoa

دیدگاهتان را بنویسید